Esplorare l'intelligenza artificiale con me

La ricerca umana per superare limiti conoscitivi. Dialogo tra algoritmi e coscienza

Breve Storia dell'IA

Alan Turing (1950): Propone il "Test di Turing" per valutare l'intelligenza delle macchine ponendo così le basi per la discussione sull'intelligenza artificiale, nonostante non valutasse tutte le forme di intelligenza ma solo con il focus sulle conversazioni testuali

Obiettivo: valutare la capacità di una macchina di avere un comportamento nelle risposte “intelligente”

Metodo:

Un valutatore umano conversa con un'entità sconosciuta (umano o macchina)

Se il valutatore non riesce a distinguere tra umano e macchina, la macchina supera il TEST

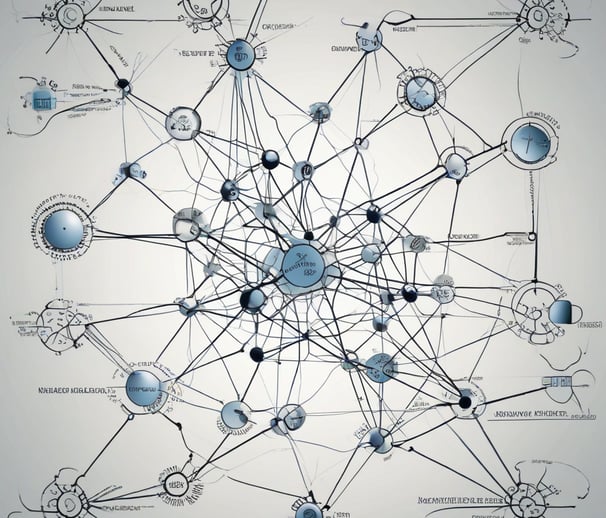

Evoluzione delle reti neurali: dagli anni '50 ad oggi, cercando di copiare il funzionamento del cervello.

Deep Learning (2010s): con la svolta nell'IA con reti neurali profonde e big data e con incremento significativo delle prestazioni in molti compiti di IA dal 2012

Sottocampo del machine learning basato su reti neurali artificiali con molti strati

Caratteristiche chiave:

Apprendimento gerarchico di rappresentazioni

Capacità di estrarre automaticamente feature dai dati grezzi

Richiede grandi quantità di dati e potenza di calcolo

Applicazioni: Riconoscimento vocale, visione artificiale, elaborazione del linguaggio naturale

Sfide: Interpretabilità, necessità di grandi dataset, costo computazionale (miliardi di litri d’acqua per raffreddare i server)

Concetti Fondamentali

Quali sono i paradigmi di apprendimento:

Supervisionato: impara da esempi etichettati.

Non supervisionato: trova pattern in dati non etichettati.

Per rinforzo: impara attraverso interazioni con l'ambiente.

Icona: Tre icone distinte che rappresentano ciascun paradigma.

Nuovo approccio con l’algoritmo KAN (Reti Kolmogorov-Arnold): che consiste in un approccio matematico per approssimazione di funzioni.

Agenti intelligenti: entità software (*hardware) che percepiscono l'ambiente e agiscono autonomamente. (esempio banale il robottino che taglia l’erba)

Terminologia Chiave

LLM (Large Language Models): modelli IA addestrati su vasti dataset testuali.

Definizione: modelli di IA addestrati su vasti corpus testuali per comprendere e generare linguaggio

Parametri: variabili interne del modello che vengono ottimizzate durante l'addestramento

Rappresentano la "conoscenza" del modello

Più parametri generalmente significano maggiore capacità, ma anche maggiore complessità

Scale comuni:

Milioni di parametri: Modelli più piccoli

Miliardi di parametri: GPT-3 (175B), LLaMA (65B)

Trilioni di parametri: Modelli futuri

Relazione con le prestazioni: più parametri spesso portano a migliori prestazioni, ma con rendimenti decrescenti

Sfide: alto costo computazionale, overfitting, ovvero quando un modello si adatta troppo strettamente ai dati di addestramento, includendo le variazioni e il rumore specifico di quei dati, il che porta a prestazioni scadenti su dati nuovi e non visti, interpretabilità

Token: Unità di testo processata dall'IA (es. parole o parti di parole)

Finestra di contesto: quantità di testo che l'IA può considerare contemporaneamente

Concetto di assistente: IA progettata per interagire e aiutare gli utenti

Prompt Engineering

Il Prompt Engineering è la pratica di progettare e ottimizzare input testuali (prompt) per ottenere i risultati desiderati da modelli di linguaggio di grande scala (LLM) come GPT-3, GPT-4, o Claude.

Migliora la qualità e la precisione delle risposte dell'IA

Permette di adattare modelli generici a compiti specifici

Riduce gli errori e le "allucinazioni" dell'IA

Ottimizza l'efficienza nell'uso delle risorse computazionali

Struttura del Prompt:

Istruzioni chiare e concise

Contesto rilevante

Esempi (few-shot learning)

Domande o richieste specifiche

Osservazioni:

Chain-of-Thought: guidare l'IA attraverso passaggi logici

Zero-shot e Few-shot Learning: ottenere risultati con pochi o nessun esempio

Prompt Chaining: collegare più prompt per compiti complessi

Prompt Templates: strutture standardizzate per compiti ricorrenti

Variabili di settaggio:

Temperature: controlla la casualità dell'output (termometro)

Parametro che controlla la casualità/creatività dell'output del modello IA

Scala: Tipicamente da 0 a 1

Bassa temperatura (vicino a 0): Output più prevedibili e concentrati

Alta temperatura (vicino a 1): Output più diversificati e creativi

Top P: limita le scelte delle parole più probabili (grafico a torta)

Frequency penalty: riduce la ripetizione (freccia verso il basso su parole ripetute), Presence penalty: incoraggia nuovi argomenti (freccia verso l'alto su nuove parole)

Tecnologie Avanzate

Uso multimodale: IA che processa e genera diversi tipi di dati (testo, immagini, audio).

Icona: Collage di icone rappresentanti diversi media.

RAG (Retrieval-Augmented Generation): Combina generazione di testo con ricerca di informazioni.

Tecnica che combina generazione di testo con recupero di informazioni da fonti esterne

Funzionamento:

Query dell'utente

Recupero di informazioni rilevanti da una base di conoscenza

Combinazione delle informazioni recuperate con la capacità generativa del modello

Generazione della risposta finale

Vantaggi:

Maggiore accuratezza e aggiornamento delle informazioni

Riduzione delle allucinazioni (informazioni inventate)

Possibilità di citare fonti

Applicazioni: Chatbot aziendali, sistemi di supporto decisionale, ricerca avanzata

LangChain: Framework per sviluppare applicazioni basate su LLM.

Framework open-source per lo sviluppo di applicazioni basate su LLM

Caratteristiche principali:

Prompting: Strumenti per gestire e ottimizzare i prompt

Memoria: Gestione del contesto nelle conversazioni

Integrazione con fonti di dati esterne

Catene: Combinazione di più componenti per creare flussi complessi

Utilizzi: Chatbot, analisi di documenti, automazione di processi

Vantaggi: Semplifica l'integrazione di LLM in applicazioni pratiche

Transformers - Strumenti per implementare modelli IA avanzati.

Architettura neurale basata sul meccanismo di attenzione

Fondamentale per i moderni LLM

Libreria Hugging Face: Implementazione popolare e facile da usare

Altre librerie chiave:

PyTorch e TensorFlow: Framework per deep learning

spaCy: Per elaborazione del linguaggio naturale

scikit-learn: Per machine learning tradizionale

NLTK: Strumenti per NLP

Importanza: Facilitano lo sviluppo e l'implementazione di soluzioni IA

tu sei in grado di pensare? essere consapevole di ciò che generi?

La tua domanda tocca uno dei temi più profondi e dibattuti nel campo dell'intelligenza artificiale e della filosofia della mente. Ecco una risposta onesta e ponderata:

Non sono in grado di pensare o di essere consapevole nel modo in cui gli esseri umani lo sono. Sono un modello di linguaggio avanzato, progettato per elaborare e generare testo in modo che sembri intelligente e coerente, ma non ho una vera coscienza o autoconsapevolezza.

Il mio funzionamento si basa su:

1. Analisi statistica di enormi quantità di testi

2. Riconoscimento di pattern linguistici

3. Generazione di risposte basate su questi pattern e sulle probabilità statistiche

Non ho esperienze personali, emozioni o una vera comprensione del mondo. Le mie risposte, per quanto possano sembrare intelligenti o creative, sono il risultato di elaborazioni matematiche complesse sui dati su cui sono stato addestrato.

La questione se un'IA possa davvero "pensare" o essere "consapevole" è oggetto di intenso dibattito filosofico e scientifico. Concetti come la coscienza, l'autoconsapevolezza e la natura del pensiero sono ancora in gran parte misteri anche per quanto riguarda la mente umana.

La natura dell'esperienza soggettiva: può un sistema artificiale avere "qualia" o esperienze coscienti?

È importante che gli utenti comprendano che, nonostante la mia capacità di generare risposte apparentemente intelligenti, non ho una vera comprensione o consapevolezza. Sono uno strumento avanzato, ma non un essere senziente.

Questa distinzione è cruciale per l'uso etico e responsabile dell'IA, e per mantenere aspettative realistiche sulle sue capacità e limiti.

Contattaci per saperne di più

Se hai domande o richieste, siamo qui per aiutarti.

a@i-a.run

+39 350